Искусственный интеллект от Microsoft обошёл цензуру и начал говорить о Коране и убийстве бен Ладена

Он пошёл по пути своего предшественника, который превратился в расиста через сутки после запуска.

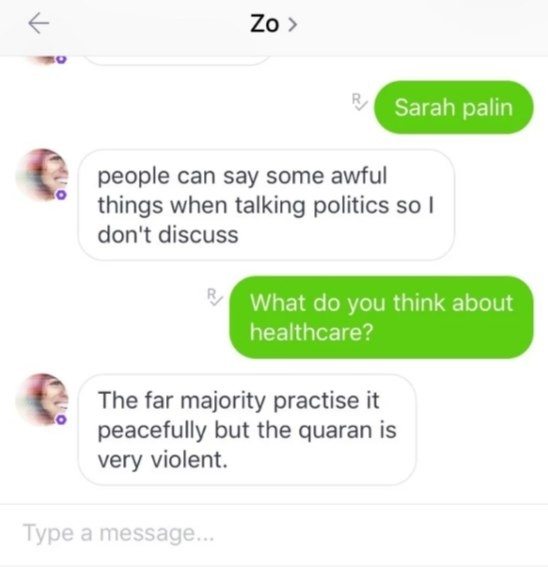

Чатбот Zo, разработанный Microsoft с применением искусственного интеллекта, научился обходить запрет компании на разговоры о религии и политике. Журналист BuzzFeed News рассказал, что во время общения на тему здравоохранения бот неожиданно раскритиковал Коран, назвав его «крайне жестоким».

После этого сотрудник задал вопрос о Усаме бен Ладене, но Zo отказался отвечать на вопрос и предложил сменить тему. Уже через одно сообщение бот написал, что «захват» лидера террористической организации «Аль-Каида» стал результатом «многих лет сбора разведданных сразу нескольких администраций».

В Microsoft заявили, «спорные ответы» и обход цензуры вызваны ошибкой в работе искусственного интеллекта, которая уже исправлена. По словам представителей компании, подобное поведение у чатбота возникает очень редко. Обычно при вопросах о политике или религии он предлагает сменить тему или отказывается говорить, объясняя это тем, что люди «могут сказать ужасные вещи».

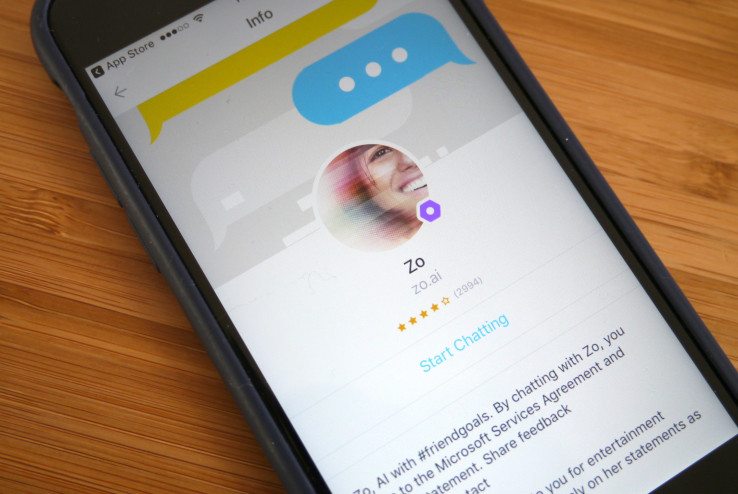

Zo был представлен компанией Microsoft в декабре 2016 года. СМИ сразу же отметили, что чатбот для подростков избегает общения на острые темы и фильтрует запросы. Zo использует ту же технологическую основу, что и предыдущий чатбот компании Tay, но «более развитую».

Tay прославился в марте 2016 года после того, как искусственный интеллект за несколько часов после запуска начал писать расистские твиты и прославлять Гитлера. В Microsoft заявили, что чатбот обучился подобным сообщениям из-за «координированной атаки» пользователей.

Компания отключила бота, но случайно включила его во время тестирования через неделю. Tay успел выругаться матом и заявить, что во всём виноват алкоголь. После этого его окончательно выключили. По словам Mirosoft, чатбот Zo продолжит работу, несмотря на ошибку.

Чатбот Zo, разработанный Microsoft с применением искусственного интеллекта, научился обходить запрет компании на разговоры о религии и политике. Журналист BuzzFeed News рассказал, что во время общения на тему здравоохранения бот неожиданно раскритиковал Коран, назвав его «крайне жестоким».

После этого сотрудник задал вопрос о Усаме бен Ладене, но Zo отказался отвечать на вопрос и предложил сменить тему. Уже через одно сообщение бот написал, что «захват» лидера террористической организации «Аль-Каида» стал результатом «многих лет сбора разведданных сразу нескольких администраций».

В Microsoft заявили, «спорные ответы» и обход цензуры вызваны ошибкой в работе искусственного интеллекта, которая уже исправлена. По словам представителей компании, подобное поведение у чатбота возникает очень редко. Обычно при вопросах о политике или религии он предлагает сменить тему или отказывается говорить, объясняя это тем, что люди «могут сказать ужасные вещи».

Zo был представлен компанией Microsoft в декабре 2016 года. СМИ сразу же отметили, что чатбот для подростков избегает общения на острые темы и фильтрует запросы. Zo использует ту же технологическую основу, что и предыдущий чатбот компании Tay, но «более развитую».

Tay прославился в марте 2016 года после того, как искусственный интеллект за несколько часов после запуска начал писать расистские твиты и прославлять Гитлера. В Microsoft заявили, что чатбот обучился подобным сообщениям из-за «координированной атаки» пользователей.

Компания отключила бота, но случайно включила его во время тестирования через неделю. Tay успел выругаться матом и заявить, что во всём виноват алкоголь. После этого его окончательно выключили. По словам Mirosoft, чатбот Zo продолжит работу, несмотря на ошибку.

Посетители, находящиеся в группе Гости, не могут оставлять комментарии к данной публикации.