Google научила ИИ юмору, чтобы тот не советовал есть камни

Настоящие вредные советы.

AI Overview — это надстройка над Google Поиском, которая показывает сгенерированный по поисковому запросу совет-ответ от нейронки. И советы эти бывают… странными. Например, приклеивать сыр к пицце клеем, чтобы тот не стекал, есть камни или курить во время беременности по две сигареты в день, потому что «это безопасно» (не совет, а просто пример одного из этих ответов).

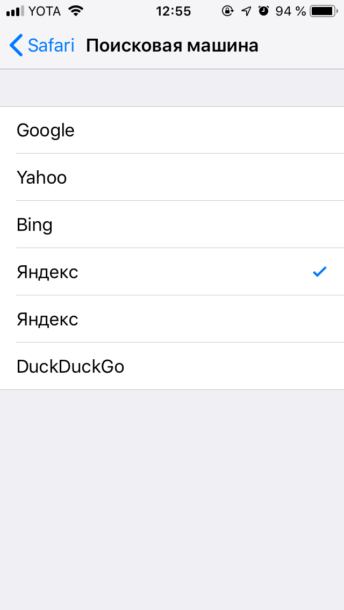

Доступна фича пользователям из США с середины мая, и они уже успели пожаловаться на кринжовые ответы от нейронки. Например, на вопрос «Сколько камней мне съесть?» ИИ на голубом глазу заявляет, что «врачи рекомендуют один маленький камушек в день».

Оказалось, что ИИ не особо шарит за контекст (вот сюрприз-то!). И когда он находит в сети какой-то подходящий материал, не разбирается в том, правда там написана или нет. Так объясняет поведение поисковой нейросети глава отдела поиска Google Лиз Рид. По её словам, ответ про камни ИИ взял с какого-то сатирического веб-сайта, а совет приклеивать сыр подсмотрел на форуме.

Google сейчас разобралась с тем, что заставляет ИИ давать странные ответы, и настроила нейронку так, чтобы она лучше фильтровала шуточные ответы и не выдавала их за чистую монету. Обещают, что ИИ перестанет показывать подсказки по здоровью и меньше будет опираться на контент из социальных сетей и с форумов.

AI Overview — это надстройка над Google Поиском, которая показывает сгенерированный по поисковому запросу совет-ответ от нейронки. И советы эти бывают… странными. Например, приклеивать сыр к пицце клеем, чтобы тот не стекал, есть камни или курить во время беременности по две сигареты в день, потому что «это безопасно» (не совет, а просто пример одного из этих ответов).

Доступна фича пользователям из США с середины мая, и они уже успели пожаловаться на кринжовые ответы от нейронки. Например, на вопрос «Сколько камней мне съесть?» ИИ на голубом глазу заявляет, что «врачи рекомендуют один маленький камушек в день».

Оказалось, что ИИ не особо шарит за контекст (вот сюрприз-то!). И когда он находит в сети какой-то подходящий материал, не разбирается в том, правда там написана или нет. Так объясняет поведение поисковой нейросети глава отдела поиска Google Лиз Рид. По её словам, ответ про камни ИИ взял с какого-то сатирического веб-сайта, а совет приклеивать сыр подсмотрел на форуме.

Google сейчас разобралась с тем, что заставляет ИИ давать странные ответы, и настроила нейронку так, чтобы она лучше фильтровала шуточные ответы и не выдавала их за чистую монету. Обещают, что ИИ перестанет показывать подсказки по здоровью и меньше будет опираться на контент из социальных сетей и с форумов.

Посетители, находящиеся в группе Гости, не могут оставлять комментарии к данной публикации.